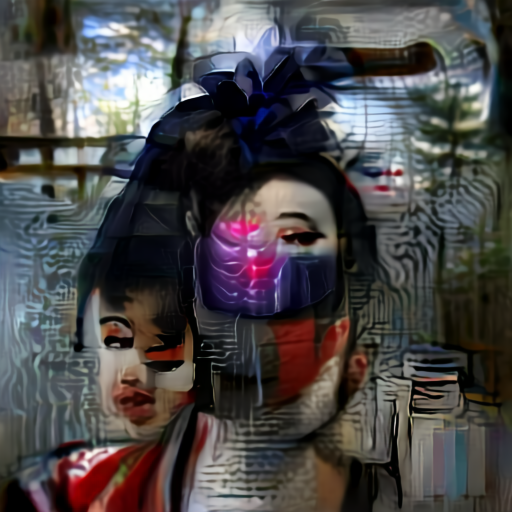

Il "Ritratto di una Geisha Cibernetica" qui a fianco è generato dal codice di machine learning di questo Google Colab Jupyter Notebook: Aleph 2 Image, creato da Ryan Murdock.

E' uno dei primi esempi di utilizzo di DALL-E (notebook di esempio) con CLIP (Contrastive Language-Image Pre-Training). CLIP è un modello che è stato originariamente inteso per la ricerca della migliore corrispondenza a una descrizione (es: "un cane che suona il violino") tra un certo numero di immagini. Abbinando una rete che può produrre immagini (un "generatore" di qualche tipo) con CLIP, è possibile modificare l'input del generatore per cercare di far corrispondere l'immagine generata alla descrizione.

La prima iterazione di questo metodo usava una rete SIREN come generatore, ed è stata chiamata "DeepDaze" in parte perché le immagini hanno una qualità da "deep dream", un sogno febbrile e nebuloso. La successiva iterazione ha usato BigGAN ed è stata chiamata BigSleep proprio come allusione a DeepDream e al film noir surrealista "The Big Sleep". Il secondo riferimento è sempre dovuto alla sua strana qualità onirica.

Infine, Aleph2Image usa il decoder discreto VQ-VAE di DALL-E. Si chiama così in riferimento a The Aleph, un racconto di Borges su un oggetto che può mostrare tutto il mondo in una volta. Inoltre, include una citazione sulla sorpresa dal racconto.

DALL·E: Generate Images from Text Captions

twitter

Thoughts on DeepDaze, BigSleep, and Aleph2Image

★ DALL-E 2 shows the power of generative deep learning

★ The Dall-E Prompt Book by dallery.gallery

★ Opinion: OpenAI’s DALL-E 2 is the big tech equivalent of ‘soylent green’

First look - 1,000 Robots by OpenAI Design Director - DALL-E 2 (3.5B) by OpenAI - Launched Apr/2022

OpenAI DALL·E: Creating Images from Text (Blog Post Explained)

Add new comment