Il Nuovo Flash da Anthropic

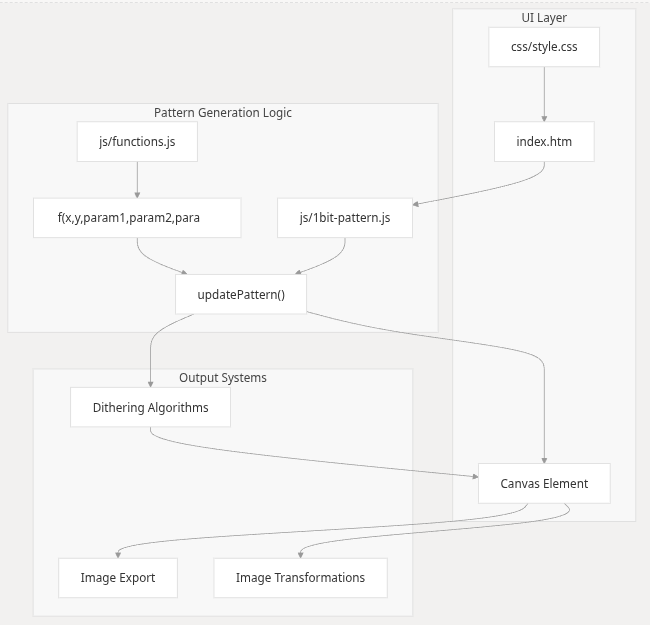

Gli Artifacts di Claude evocano Flash e le sezioni animate e interattive del web di 20 anni fa. Solo che ora basta descrivere cosa si desidera ottenere, con ottima proprietà di linguaggio e l'abilità di dettare i requisiti senza sottintesi, e vedere Claude che si occupa di redigere HTML, CSS e file javascript per realizzare lo sviluppo e mostrarlo dopo pochi istanti direttamente nel browser.

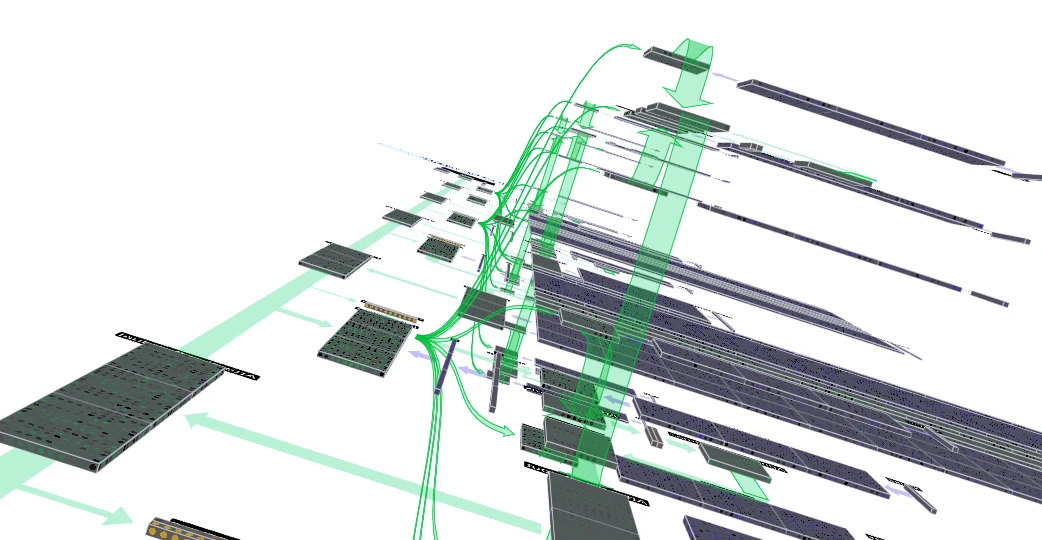

Anthropic summons the spirit of Flash games for the AI age